Exlíder del equipo ético de IA de Google: “Las redes sociales son un sistema de información totalmente insano”

La etíope Timnit Gebru, experta en inteligencia artificial y ética y cofundadora que dirigió el equipo ético de IA de Google hasta que fue despedida por alertar la discriminación en ciertos algoritmos de la industria, critica al sector tecnológico y considera urgente avanzar en su regulación.

- T+

- T-

En 2020, Timnit Gebru fue despedida de Google, donde trabajaba como codirectora del equipo de investigación de Inteligencia Artificial (IA) y Ética, luego de alertar sobre la discriminación en ciertos algoritmos de la industria.

La científica y originaria de Etiopía, contó en entrevistas y en su cuenta de Twitter que, luego de criticar públicamente la censura de la multinacional a un artículo académico donde exponía el sesgo en ciertos algoritmos de IA, fue notificada por correo de su despido.

Después del suceso, 2.695 trabajadores de Google y 4.302 académicos de todo el mundo firmaron una carta de apoyo a Gebru, generando revuelo mundial en la industria.

Durante su carrera, la etíope se especializó en la investigación del sesgo de información y discriminación en algoritmos de IA, es decir, cómo el sistema informático es influenciado por los valores de quien lo codifica. Realizó un doctorado en la Universidad de Stanford e hizo un postdoctorado en Microsoft Research en Nueva York en el grupo FATE (Equidad, Responsabilidad, Transparencia y Ética en IA). Entre su trabajo destaca un artículo donde descubrió que ciertos sistemas de reconocimiento facial funcionaban 35 veces mejor con hombres blancos que con mujeres negras, lo que podía inducir a error.

Además, en 2015 cofundó Black in AI, organización sin fines de lucro que se dedica a promover la inclusión de personas negras en el campo de la inteligencia artificial.

La semana pasada, Gebru expuso en el Congreso Futuro 2022, el encuentro de Ciencia y Tecnología organizado por la Fundación Encuentros del Futuro, el Senado y el Ministerio de Ciencia.

En entrevista con DF, la experta criticó el marco ético con el que trabajan los grandes desarrolladores mundiales de tecnología y las redes sociales, a las que describió como un “ecosistema de información totalmente insano”.

-¿Cuál es tu opinión sobre las “burbujas de filtro”, estos algoritmos que utilizan las redes sociales para mostrar solo contenido similar al que consume el usuario?

-Yo soy de Etiopía y nada de todo lo que he leído podría haberme preparado para lo que estoy viendo ahora. En Eritrea (país que limita con Etiopía) hay una guerra genocida y mucho discurso de odio que la avala. Esto se acompaña con mucha desinformación coordinada, hay gobiernos que la utilizan como una propaganda. Lo mismo en Siria, hay todo un esfuerzo concertado para confundir a la gente.

He visto en investigaciones cómo maquinan para manipular los medios de comunicación social, creando cuentas y noticias falsas y, ahora con la IA, se pueden generar imágenes falsas. Hay un aumento del autoritarismo en el mundo. Inicialmente pensamos que las redes sociales estaban ayudando -yo he podido conectar con refugiados-, pero la mayor parte de la forma en que se utilizan es como un arma para silenciar y manipular los comportamientos de las personas.

-¿Cree que las redes sociales son en parte responsables de este aumento del discurso de odio?

-No sé si puedo decir que son responsables, pero están siendo utilizadas como armas para eso y definitivamente no están preparadas para responder. Y eso para mí es aterrador.

-¿Qué deberían hacer las multinacionales detrás de las redes al respecto?

-Sinceramente, creo que se trata de regularlo, porque ellos pueden ahorrar mucho dinero al no poner la cantidad de recursos que se necesitan para combatir esta situación. Y una empresa no va a decidir ganar menos dinero si no se lo exige la ley. Por ejemplo, Facebook podría limitar cuánto se comparte para tipos específicos de cuentas o publicaciones, pero no lo hará, porque impacta el crecimiento.

-¿Se puede regular sin chocar con principios como la libertad de expresión?

-Cuando se habla de libertad de expresión se está pensando en los derechos del que habla y no de quien escucha. Las democracias dependen de un sistema de información saludable, y las redes sociales son un sistema de información totalmente insano. Tienen miedo a que la ley los haga responsables de algunos de los contenidos que difunden, porque entonces tendrían que ser realmente cuidadosos. Ahora, simplemente difunden cosas a escala, solo pensando en el crecimiento y el dinero, y no en la seguridad. Por ejemplo, para mí, algo mínimo es que si no entiendes el idioma de un país, no deberías operar en ese lugar, pero se hace igual.

Eso afecta también al periodismo, porque si intentas hacer todas las verificaciones debidas para una publicación, terminas sin dinero.

La inteligencia artificial

-¿En qué cosas cotidianas pueden afectar los sesgos algorítmicos a las personas?

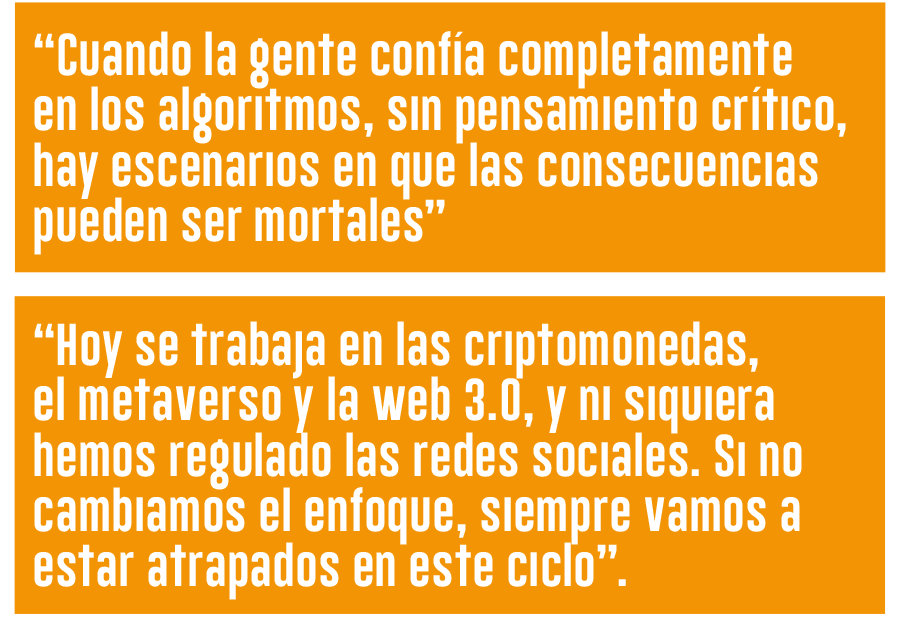

-Hace algún tiempo una adolescente quería ir a patinar en hielo y le impidieron entrar porque el reconocimiento facial la identificó como una criminal. También supe de un palestino que fue arrestado porque publicó “buenos días” en Facebook y el algoritmo lo tradujo como “atácalos”. Más tarde lo dejaron ir. Cuando la gente confía completamente en los algoritmos, sin pensamiento crítico, hay escenarios en que las consecuencias pueden ser mortales.

-¿En las grandes compañías que trabajan con IA, ves disposición para avanzar hacia un uso ético?

-No, porque van donde está el dinero y la mayor cantidad de eso está en vigilar a los inmigrantes, como si fueran todos criminales, cuando muchos solo están escapando para tener una vida. Y los gobiernos no están dando incentivos diferentes, ni castigos duros por hacer algo poco ético. Mientras, los desarrolladores no quieren regulación de mano dura, por lo que muestran unos principios extremadamente generales que al final pueden interpretar como ellos quieran para argumentar a los legisladores que ya están haciendo lo necesario.

-Mirándolo al revés, ¿cómo podemos combatir la discriminación a través de la tecnología?

-He intentado abogar por desacelerar los desarrollos. En EEUU hay una narrativa dominante arraigada en la supremacía blanca y lo patriarcal y, si no te detienes a combatirlo activamente, lo que salga a la superficie va a ser más de eso.

Hay que cambiar las estructuras, si lo miramos solo como un problema técnico no lo resolveremos. Por ejemplo, ¿por qué Google puede despedirme tan fácilmente solo porque hablé de discriminación en los algoritmos y el lugar de trabajo? ¿Cómo podemos progresar así? Creo que la raíz de esto es que hay que dar más poder a las minorías.

-¿Por eso nace Black in AI?

-Cuando estaba en el posgrado leí un artículo de una empresa que vendía un software que pretendía predecir cuando una persona iba a cometer un crimen de nuevo y así decidir cuánto tiempo de cárcel o cuánta fianza establecer para esa persona. Como mujer negra en EEUU pensé inmediatamente: “Dios mío”. Y muchos de mis compañeros no parecían darse cuenta de que el racismo existía. Al mismo tiempo, no había gente negra en IA. Por eso forme una organización para colaborar entre nosotros, que empezó a crecer.

Damos becas, ayudamos a otros a ingresar a sus posgrados. Actualmente estamos desarrollando un programa de emprendimiento para ayudar a startups a conectar con fondos de inversión. El año pasado dejé la presidencia, ahora otras personas dirigen la organización.

El Rol del Estado

-¿Crees que hay políticas públicas que puedan ayudar a superar la discriminación en la tecnología?

-Creo que la Unión Europea (UE) ha tenido un buen comienzo. En ese parlamento dije que me gustaría un enfoque más proactivo. Hoy se lanza una tecnología, se ocupa en todas partes del mundo y luego tratamos de regularla. Para ese momento, las empresas ya han pasado a la siguiente tecnología. Hoy se trabaja en las criptomonedas, la web 3.0, el metaverso, y ni siquiera hemos regulado las redes sociales. Si no cambiamos el enfoque, siempre vamos a estar atrapados en este ciclo.

-Los desarrolladores podrían decir que es restrictivo.

-Hay demasiado dinero en la industria de la IA y en el mundo del software en general, porque cualquier otra industria no puede moverse tan rápido. Hoy una compañía no puede construir un auto y simplemente ponerlo en la carretera, hay un montón de asuntos de seguridad que regular. Las empresas tecnológicas deberían hacer lo mismo.

-En Chile, la nueva Constitución se está escribiendo con paridad de género y escaños reservados para los pueblos indígenas. ¿Cree que esta inclusión en espacios públicos es importante?

-Absolutamente, me alegro de estos asientos reservados, pero esto realmente tiene que ir acompañado de cambios profundos, no sirve de nada si se queda en solo en cambiarle la cara a una estructura problemática. A mí, la persona que me despidió de Google era una mujer.

"He visto mucho daño

con el reconocimiento facial"

Gebru señala que los algoritmos que afectan a los ciudadanos, como el reconocimiento facial, deben ser públicos. Plantea que "deberíamos saber cuándo y cómo se utilizan estos algoritmos. Muchas entidades como el FBI tienen contratos con Clearview AI, que claramente ha violado la ley en la forma en que obtiene sus datos. Hay organizaciones que luchan por transparentar esto, pero esto no debería así, debería hacerse público para que la gente pueda conocer lo que se está utilizando", dice.

Rechaza de plano alguna utilidad del reconocimiento facial para la sociedad. "No se me ocurre alguna, he visto mucho daño con el reconocimiento facial e imagino aún más. Es como preguntarse si podemos usar un tanque para algo bueno, cuando todos sabemos que se hizo para la guerra. En este caso, la tecnología se desarrolló para vigilancia y, ahora que descubrimos el daño, deberíamos ser capaces de decir que no. Si queremos algo bueno, construyamos algo para ese propósito", dice.