Experta en IA: “Antropomorfizar hasta proyectar responsabilidades en un robot supone un gran riesgo para la sociedad”

La experta en interacciones sociales y afectivas entre humanos y máquinas advierte de los riesgos que implica seguir desarrollando robótica sin regulación.

- T+

- T-

Desde las novelas de Isaac Asimov hasta androides con emociones en Blade Runner y Joaquin Phoenix enamorado de su computadora en Her, la pregunta de hasta qué punto los robots pueden adoptar conductas humanas, lleva años en la sociedad, ya sea en el cine, la literatura o en la investigación científica.

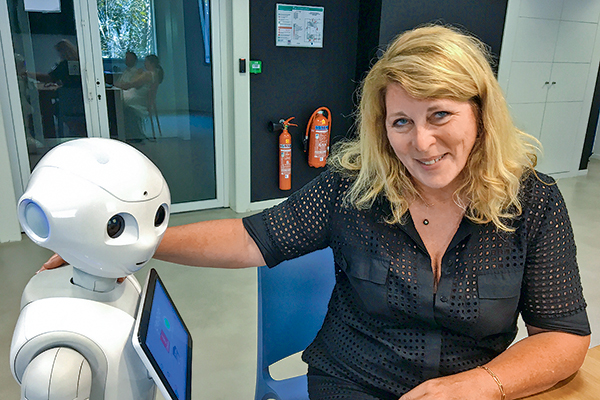

La doctora en informática Laurence Devillers se ha especializado en ética, Inteligencia Artificial (IA) y robótica, concentrando su investigación en las interacciones sociales y afectivas entre humanos y máquinas.

Sus principales áreas de trabajo incluyen el aprendizaje profundo, el procesamiento del lenguaje y la detección de emociones de los robots.

Desde 2011 es profesora de IA y ética en la Universidad de París-Sorbonne e investigadora del Laboratorio de Ciencias de la Computación para la Mecánica y las Ciencias de la Ingeniería (Limsi) en el Centro Nacional de Investigación Científica de Francia. Además, dirige un grupo de “coevolución robot-humana” en la Universidad de París-Saclay.

En enero, la científica expuso su charla “Robots que sienten” en el Congreso Futuro, contexto en el que fue entrevistada por DF, donde habló de la robótica y sus conflictos éticos.

Para Devillers, el mayor desafío es “encontrar un equilibrio entre el poder económico de las nuevas innovaciones y las consecuencias indeseables que estas tienen para la sociedad”.

-¿Es posible el escenario de Blade Runner en que los robots pueden sentir?

-Estamos muy lejos de Blade Runner. Incluso con las tecnologías más potentes, las máquinas son incapaces de sentir y no tienen experiencias de carne y hueso. El diálogo generado por un modelo de lenguaje en un robot que no puede percibir físicamente, sentir o razonar como un humano, crea un universo lingüístico sin experiencia corporal.

-¿De qué manera podrían los robots modificar el comportamiento y las interacciones humanas?

-Se utilizan robots conversacionales o sociales para influenciar indirectamente a sus usuarios a través del diálogo, lo que se conoce como nudging. Todo lo que una máquina observa y detecta del comportamiento humano es el resultado de sesgos cognitivos (del desarrollador) que pueden ser explotados para modificar conductas.

-Se dice que las interacciones sociales con los robots son ilusiones para los humanos, por lo que serían poco saludables. ¿Cuál es su opinión?

-Esa ilusión puede ser útil en ciertos casos, como para tratar trastornos mentales del desarrollo, pero antropomorfizar hasta proyectar responsabilidades en un robot supone un gran riesgo para la sociedad. Pueden surgir nuevos agentes incontrolables que no obedezcan las normas sociales, por lo que es necesario vigilar continuamente el desarrollo y la difusión de esos robots y proponer medidas de regulación.

-¿Puede un robot detectar emociones humanas?

-Es difícil que detecte las emociones cotidianas complejas, pero sí es posible en las emociones prototípicas lograr un antropomorfismo afectivo, lo que puede perjudicar al usuario. Pueden haber reacciones de apego o confianza hacia el robot en lugar de hacia otros humanos. Definir los límites de la simulación afectiva de los chatbots debe implicar una reflexión sobre las aplicaciones de ellos y las vulnerabilidades humanas.

Ética en robótica

-¿Qué dificultades éticas enfrenta un desarrollador de robótica?

-Por ahora nada está regulado, necesitamos más debate. No se trata de construir robots éticos, eso no significa nada. La ética debe seguir relacionada con valores humanos. Es necesario construir normas y leyes para proteger a las personas vulnerables y a los jóvenes contra las posibles amenazas de la IA: dependencia, manipulación, aislamiento y, más peligrosamente, la vulnerabilidad mental e incluso el suicidio.

Otro desafío es que el 80% de los codificadores son hombres y el 80% de los robots sociales tienen nombres de mujer como Alexa o Samantha o rasgos femeninos. Refuerzan estereotipos de género. Los robots femeninos son asistentes, enfermeras e incluso robots sexuales. Es urgente involucrar más mujeres en la IA y la robótica.

-¿Cómo evalúa el marco ético en que trabajan los grandes desarrolladores?

-No está suficientemente maduro. Hemos tomado conciencia de los problemas ecológicos, pero no aún de los ético digitales. Es crucial anticiparse a desarrollos tecnológicos que modifican y cuestionan de manera permanente la relación individual y colectiva con el conocimiento, la memoria, la propiedad, la salud, el trabajo y el medio ambiente.

-¿Qué aportes pueden hacer los robots a la sociedad?

-Permiten un marco terapéutico. Por ejemplo, Moxie (robot de Embodied para asistir a niños) puede ser un compañero para niños con trastorno de desarrollo (TDC) y proporcionarles un entorno seguro y protegido con contenidos basados en estrategias terapéuticas.