Las "alucinaciones" que atormentan a la IA: por qué los chatbots tienen dificultades para decir la verdad

Las tecnológicas intensifican esfuerzos para reducir respuestas inventadas, pero eliminarlas parece imposible.

Por: Financial Times

Publicado: Miércoles 23 de julio de 2025 a las 04:00 hrs.

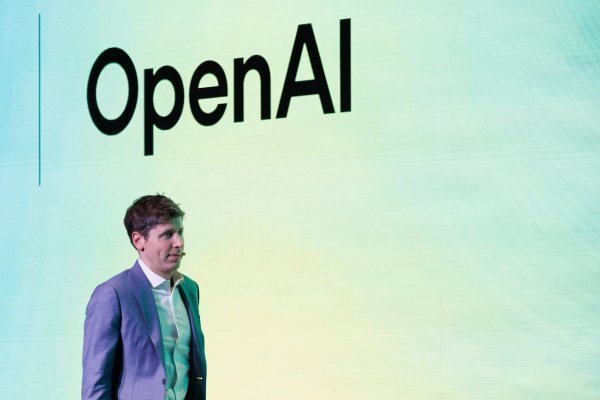

Foto: Bloomberg

Noticias destacadas

Los principales grupos de inteligencia artificial (IA) del mundo están intensificando sus esfuerzos para reducir la cantidad de “alucinaciones” en los modelos de lenguaje de gran escala, al tratar de resolver uno de los mayores obstáculos que limitan la adopción de esta poderosa tecnología.

Google, Amazon, Cohere y Mistral están entre los que buscan disminuir la tasa de estas respuestas inventadas mediante la implementación de soluciones técnicas, la mejora en la calidad de los datos que entrenan a los modelos de IA, y la construcción de sistemas de verificación y chequeo de hechos en sus productos de IA generativa.

El impulso por reducir estas llamadas alucinaciones se considera clave para aumentar el uso de herramientas de IA en industrias como la legal y la de salud —que requieren información precisa— y así contribuir al crecimiento de los ingresos del sector de la IA.

Esto ocurre mientras los errores de los chatbots ya han resultado en costosos desaciertos y litigios. El año pasado, un tribunal ordenó a Air Canada respetar un descuento que su chatbot de servicio al cliente había inventado, y abogados que usaron herramientas de IA en documentos judiciales fueron sancionados después de que estas fabricaran citas legales.

Pero los expertos en IA advierten que eliminar por completo las alucinaciones de los modelos de lenguaje de gran escala es imposible, debido a cómo funcionan estos sistemas.

“Las alucinaciones son un problema muy difícil de resolver por la naturaleza probabilística de cómo operan estos modelos”, dijo Amr Awadallah, exejecutivo de Google y fundador de Vectara, una startup de agentes de IA generativa. “Nunca lograrás que dejen de alucinar".

Estos errores ocurren porque los modelos de lenguaje están diseñados para predecir la siguiente palabra más probable en una oración, basándose en estadísticas aprendidas de sus datos de entrenamiento.

Los errores pueden manifestarse como inexactitudes fácticas o como fallos en seguir instrucciones, por ejemplo, al resumir eventos del año equivocado. Los datos que se usan para entrenar un modelo de IA son importantes, porque mientras más veces aparece una información, más probable es que el modelo la repita.

La cantidad de alucinaciones en los modelos de IA varía significativamente. Vectara, que creó una tabla de clasificación para seguir estos errores, descubrió que algunos modelos pueden alucinar tan solo el 0,8 % de las veces, mientras que otros lo hacen hasta un 29,9 % cuando se les pide resumir un documento.

La tasa de alucinaciones aumentó inicialmente con una nueva generación de modelos de IA capaces de “razonar”, es decir, resolver problemas paso a paso. Esto se debe probablemente a que estos modelos hacen muchas iteraciones internas para resolver problemas de distintas formas, lo que incrementa la probabilidad de errores, explicó Awadallah. Sin embargo, añadió que la tasa ha bajado a medida que las empresas han aprendido a construir mejores salvaguardas para estos modelos.

Pero su investigación mostró que cuando los sistemas de IA están “anclados” a otras fuentes de información —como búsquedas en línea, artículos de noticias o documentos internos de una empresa— en lugar de depender solo de sus datos de entrenamiento, la cantidad de errores se reduce considerablemente.

Los grupos de IA se han enfocado en este enfoque “anclado” para encontrar los mejores métodos que ayuden a reducir las alucinaciones al máximo.

Una técnica común utilizada por los laboratorios se llama retrieval-augmented generation (RAG), que busca información de fuentes externas y puede usarse para verificar los datos que afirman los sistemas de IA.

Los chatbots de compañías como Cohere, Mistral, Google DeepMind, OpenAI y Anthropic ofrecen citas, que muestran a los usuarios las fuentes en las que basaron los textos generados.

En enero, la startup francesa de IA Mistral firmó un acuerdo multimillonario en euros con Agence France-Presse para incorporar miles de artículos de la agencia de noticias a su chatbot y así reforzar la verificación de hechos.

Tanto Mistral como la canadiense Cohere también permiten que sus modelos se conecten con fuentes de datos internas de sus clientes, lo que les permite referirse a documentos internos para verificar información. De esta forma, el modelo se basa en el contexto y la información que el cliente desea procesar.

“Si quieres que el modelo no alucine y sea muy preciso... la mejor forma es conectarlo a las bases de datos internas”, dijo Alexandre Sablayrolles, quien lidera el trabajo sobre agentes y RAG en Mistral.

Byron Cook, vicepresidente y científico en Amazon Web Services, cree que aplicar lógica matemática y razonamiento también puede ayudar a minimizar las alucinaciones.

Esto llevó al grupo a introducir en diciembre una nueva salvaguarda llamada automated reasoning checks (verificaciones de razonamiento automatizadas), que funciona como una prueba adicional de los modelos para validar la precisión de sus respuestas.

Algunas empresas, como Google DeepMind, Cohere, Mistral y Vectara, también utilizan modelos de lenguaje más pequeños, llamados “evaluadores”, entrenados específicamente para revisar las salidas de otro modelo en busca de errores.

La mayoría de los modelos ofrecen a los desarrolladores la opción de ajustar la llamada temperatura, que controla cuán aleatoriamente debe generar el modelo la siguiente palabra probable.

Pero incluso las soluciones técnicas más rigurosas no garantizarán una veracidad total, advirtió Nick Frosst, cofundador de Cohere.

“No es como si pudiéramos entrenar un modelo para que solo diga cosas verdaderas, porque lo que es verdad depende de lo que esté pasando en el mundo”, dijo Frosst. “Y eso está cambiando, y en algunas situaciones también depende de tu punto de vista.”

Permitir que los modelos de IA busquen información en internet también los hace susceptibles a un tipo de ataque llamado prompt injection, señaló Awadallah, de Vectara.

Este ataque consiste en que un tercero inserta información falsa en los sitios donde los modelos buscan datos, como páginas web, Reddit o Wikipedia. Esa información puede llevar a que el modelo presente datos falsos como si fueran verdaderos, o que ignore sus salvaguardas y se “porte mal”.

Cuando Google lanzó su nueva herramienta de búsqueda con IA el año pasado, esta dijo a los usuarios que pusieran pegamento en la pizza y que comieran piedras, luego de que alguien publicara eso en Reddit como una broma.

Parte del desafío para los desarrolladores de IA es alcanzar un equilibrio entre verificar la precisión de la información y permitir que el modelo sea “creativo”.

“Incorporar creatividad en los modelos los hace más útiles, pero también puede llevar a respuestas más creativas que factuales”, señaló Google DeepMind.

Cook, de AWS, observó que a veces las alucinaciones también pueden ser “deseadas” por los usuarios.

“Si estás tratando de escribir poesía con ellos, entonces eso es bastante bueno. Estás buscando respuestas raras que encuentren conexiones inusuales entre cosas”, dijo Cook. “Y para eso son realmente buenos los modelos transformadores.”

Frosst, de Cohere, advirtió que incluso el término alucinación puede ser engañoso. “Suena demasiado a que [el modelo] funciona como el cerebro humano, y no es así”, afirmó. “Funciona de una manera completamente diferente.”

Te recomendamos

ARTICULOS RELACIONADOS

Newsletters

LO MÁS LEÍDO

MOP descarta impacto en la construcción de Red de Hospitales del Biobío ante solicitud de quiebra de OHLI

El seremi de Obras Públicas del Biobío aseguró que la insolvencia de la filial de montaje industrial del holding OHL no afectará la construcción de los cuatro recintos médicos ni las obras viales en curso.

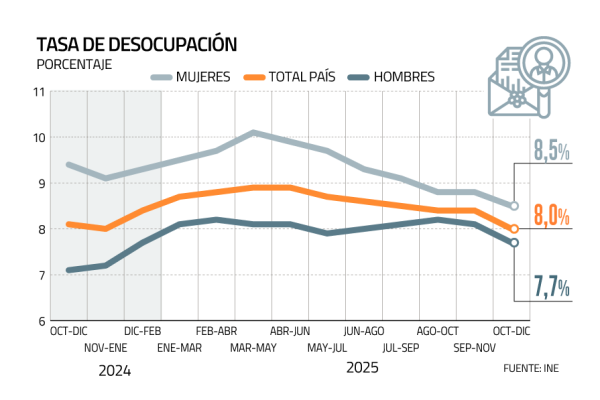

Tasa de desocupación nacional sube a 8,3% en el trimestre noviembre 2025-enero 2026, sobre las expectativas

El INE informó que en 12 meses el indicador registró un aumento de 0,3 puntos porcentuales por un alza de la fuerza de trabajo (1,4%), mayor a la presentada por las personas ocupadas (1,2%).

BRANDED CONTENT

Dra Susan Bueno y el impulso que la mueve a avanzar, investigar y aportar a la sociedad.

Su curiosidad temprana la llevó a estudiar las enfermedades infecciosas y a contribuir en el desarrollo de la primera vacuna aplicada masivamente en Chile contra el Covid-19. Hoy, la Dra. Susan Bueno, reconocida en 2024 como inventora del año, continúa aportando desde la investigación al fortalecimiento de la salud. Mira aquí su entrevista

Dra Susan Bueno y el impulso que la mueve a avanzar, investigar y aportar a la sociedad.

Su curiosidad temprana la llevó a estudiar las enfermedades infecciosas y a contribuir en el desarrollo de la primera vacuna aplicada masivamente en Chile contra el Covid-19. Hoy, la Dra. Susan Bueno, reconocida en 2024 como inventora del año, continúa aportando desde la investigación al fortalecimiento de la salud. Mira aquí su entrevista

Jorge Carinao: la fuerza de creer cuando todo parece imposible

Te invitamos a conocer la historia de Jorge Carinao, deportista paralímpico chileno que ha transformado la adversidad en fuerza y el esfuerzo en orgullo nacional, demostrando que no existen límites cuando hay convicción y sueños claros. No te pierdas esta inspiradora entrevista

Camila Elizalde; una chef que ha hecho del perfeccionismo una fuerza transformadora

Conoce aquí la entrevista a una de las chef más destacadas a nivel nacional y americano en el arte de la pastelería. En este capítulo, Camila reflexiona sobre los desafíos de liderar en un entorno competitivo y la importancia de construir espacios donde la excelencia y la empatía convivan. Mira la entrevista haciendo aquí.

En Perfeccionistas entrevistamos a un deportista chileno que quiere llegar tan alto como sus saltos

Mauricio Molina nos cuenta de su pasión por el BMX y cómo se convirtió en el primer chileno en competir en esta disciplina en unos Juegos Olímpicos y ser parte del selecto grupo de los 25 mejores del mundo.

Instagram

Instagram Facebook

Facebook LinkedIn

LinkedIn YouTube

YouTube TikTok

TikTok