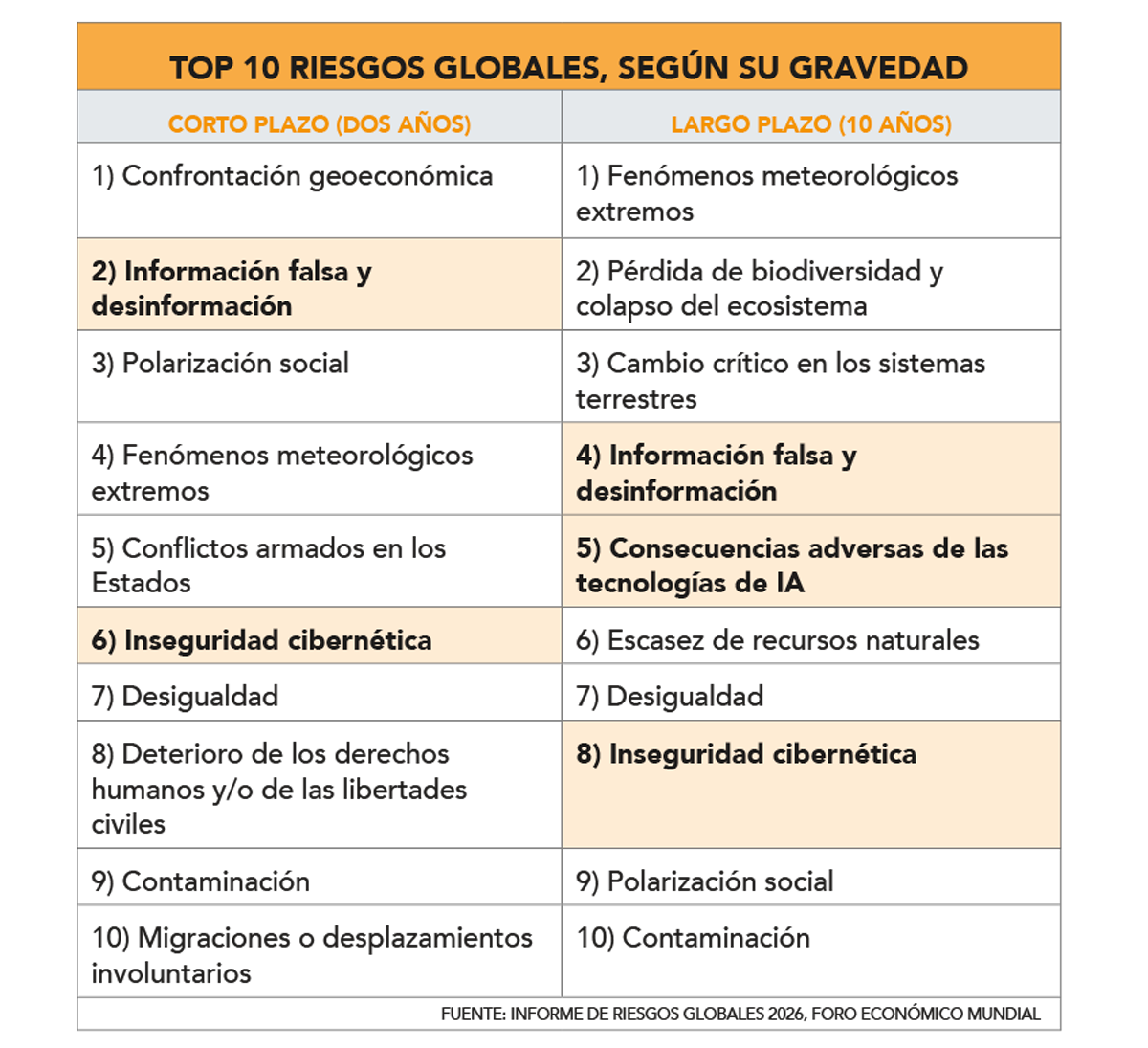

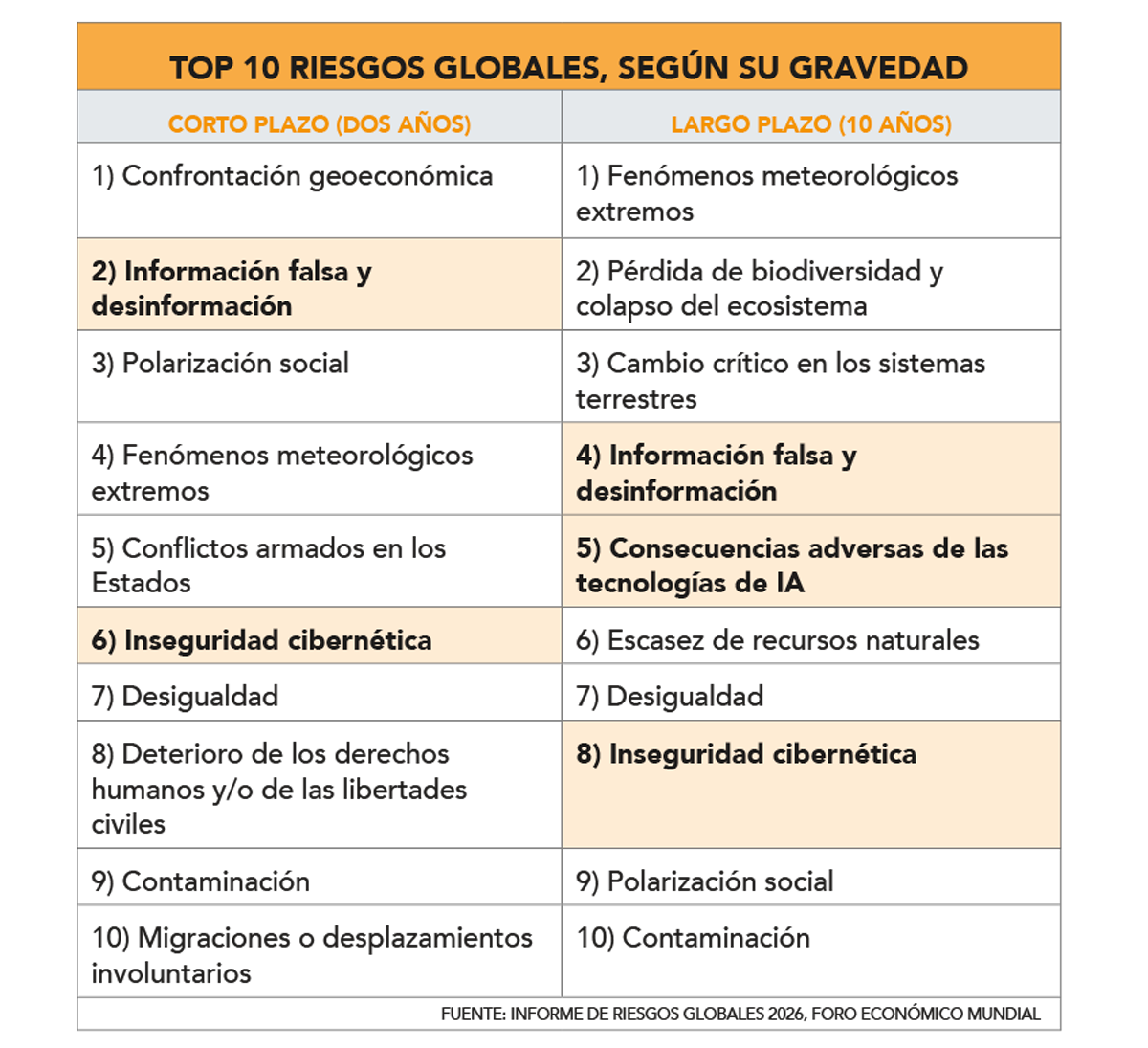

Hace unos días, el Foro Económico Mundial publicó su Informe de Riesgos Globales 2026, en el que posicionó a la confrontación geoeconómica como el principal riesgo global para este año, en un contexto marcado por crecientes tensiones entre potencias.

En ese escenario, el documento situó a la información falsa y la desinformación como el segundo mayor riesgo a dos años, ubicó a la inseguridad cibernética entre los principales riesgos estructurales, y alertó sobre el fuerte ascenso de las consecuencias adversas de la inteligencia artificial (IA), que escaló hasta el quinto lugar en el horizonte de 10 años.

En particular, el informe advirtió que la integridad de las noticias en línea y la información en general está “cada vez más amenazada”, debido a la creciente dificultad para distinguir entre contenido real y material sintético generado por IA.

Además, señaló que la proliferación de imágenes, audios y videos falsificados (deepfakes), junto con el mayor consumo de noticias a través de redes sociales y herramientas basadas en IA, está afectando la confianza pública y profundizando la polarización política y social, con impactos directos en procesos democráticos e institucionales.

El profesor del programa Wallenberg IA, Sistemas Autónomos y Software (WASP) en KTH Royal Institute of Technology, Ricardo Baeza-Yates, afirmó que el mundo “ya entró” en una crisis global de confianza en la información, marcada por el rol de la IA en las campañas de desinformación ante los procesos electorales de 2024 y 2025, y que el avance de esta tecnología está complicando la capacidad de verificar la legitimidad de imágenes e información que se difunde en línea.

El también cofundador y CSO de Theodora AI indicó que los medios, las plataformas y las democracias “están muy poco preparadas” para enfrentar el aumento en la proliferación de deepfakes y la desinformación generada por la IA, pero destacó el caso de China como el país con la “mejor regulación” del uso de esta tecnología.

Además, enfatizó en la necesidad de avanzar en leyes que obliguen a los modelos de IA a contar con herramientas, como marcas de agua digitales “difíciles de copiar y modificar”, que permitan verificar el contenido generado por inteligencia artificial.

Ante los efectos adversos de la IA, el reporte advirtió que su adopción acelerada podría generar impactos significativos en los mercados laborales y las habilidades humanas, y aumentar el riesgo de “fallas en cadena en ámbitos interconectados”.

También alertó sobre una posible pérdida de control sobre sistemas cada vez más autónomos, lo que podría “erosionar de forma constante la influencia humana sobre la economía, la cultura, la gobernanza y los sistemas sociales”.

Según Baeza-Yates, los trabajos más expuestos a esta disrupción son aquellos “simples, repetitivos y fáciles de imitar por un algoritmo”, como tareas administrativas y “de papeleo”, donde agentes digitales podrían reemplazar funciones humanas con mayor rapidez.

Por otro lado, el académico indicó que la IA está ampliando la brecha digital, debido a que “el 55% de la población” no cuenta con acceso o habilidades para beneficiarse de estas tecnologías, y agregó que su mayor adopción amplificará otros riesgos, como la polarización social y la influencia en los problemas de salud mental, aludiendo a los casos de suicidio asistidos por modelos de IA.

Inseguridad cibernética

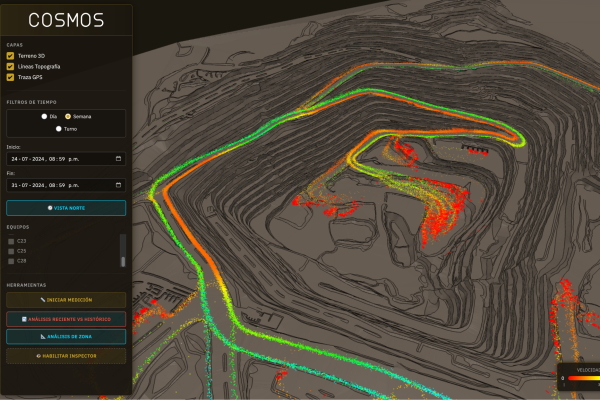

En el ámbito de la inseguridad cibernética, el reporte indicó que la digitalización y la automatización de la infraestructura crítica está creando un nuevo frente de vulnerabilidad “ciberfísica”, donde los sistemas y dispositivos de control industrial pueden llegar a estar “insuficientemente protegidos y supervisados”.

El documento advirtió que estas amenazas resultan especialmente atractivas para actores gubernamentales y cibercriminales, al permitir negar responsabilidad y dificultar respuestas diplomáticas y legales.

En este escenario, el socio líder de Ciberseguridad de EY, Facundo Jamardo, destacó el rol de la consolidación de la ciberguerra y el uso intensivo de IA para automatizar ataques, lo que ha reducido los tiempos necesarios para identificar y explotar vulnerabilidades. Señaló que hoy los ciberataques operan de manera continua, y con una velocidad que supera la capacidad de respuesta de muchas organizaciones.

“Hoy tienes agentes con la capacidad de operar como un hacker que trabaja 24/7, que permiten conseguir resultados de vuelta razonables y en muy poco tiempo, sobre todo teniendo en cuenta que las empresas no tienen todavía un músculo de protección 24/7. Entonces, hay mucha infraestructura que no ha tenido el nivel de securización adecuado”, afirmó.

Jamardo agregó que uno de los principales desafíos para los próximos años será la demanda de capacidades humanas y técnicas para operar esquemas de protección frente a la digitalización de procesos, junto con establecer controles de seguridad de terceros y proveedores en cadenas productivas y de servicios.

“La gran mayoría de las empresas en Chile no han hecho nada respecto a cómo saber el nivel de seguridad de terceros”, añadió.

Instagram

Instagram Facebook

Facebook LinkedIn

LinkedIn YouTube

YouTube TikTok

TikTok {{/if}}

{{/if}}